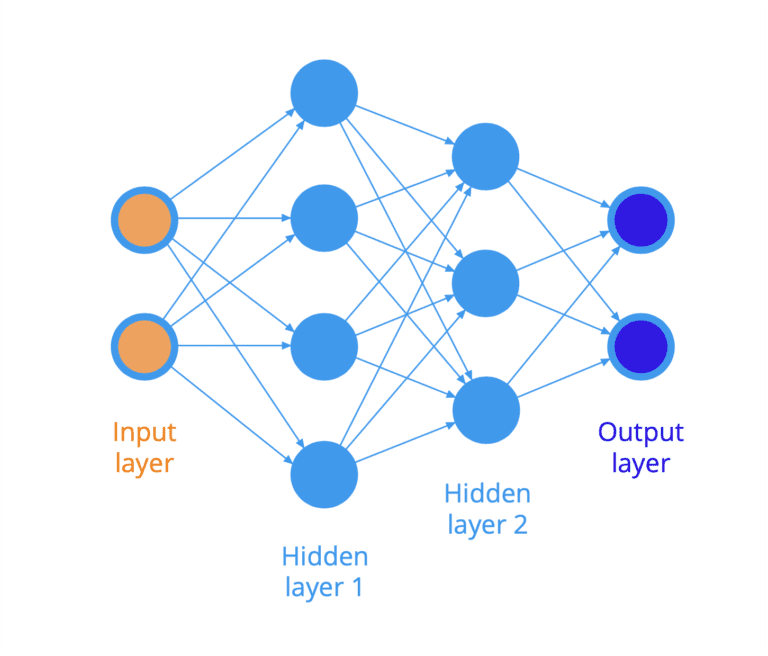

인공 신경망은 입력과 출력 간의 매핑을 근사화하는 계산 모델입니다. 그것은 이웃 뉴런으로부터 일련의 자극을받을 때 정보를 전파하는 상호 연결된 뉴런의 네트워크로 유사하게 구성되어 있다는 점에서 인간 두뇌의 구조에서 영감을 받았습니다. 신경망 훈련에는 역전파 알고리즘과 경사하강법 알고리즘을 함께 사용하는 프로세스가 포함됩니다. 앞으로 살펴보겠지만 이 두 알고리즘은 모두 미적분학을 광범위하게 사용합니다. 이 튜토리얼에서는 미적분학의 측면이 신경망에 어떻게 […]

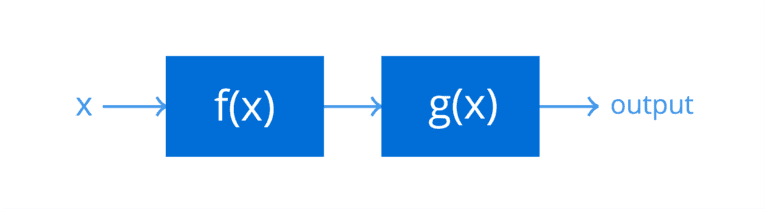

체인 규칙을 사용하면 복합 함수의 도함수를 찾을 수 있습니다. 피드포워드 신경망을 훈련시키기 위해 역전파 알고리즘에 의해 광범위하게 계산됩니다. 특정 연산 순서를 따르면서 효율적인 방식으로 체인 규칙을 적용함으로써 역전파 알고리즘은 네트워크의 각 가중치에 대한 손실 함수의 오차 기울기를 계산합니다. 이 튜토리얼에서는 일변량 함수와 다변량 함수에 대한 미적분학의 연쇄 규칙을 발견하게 됩니다. 이 자습서를 완료하면 다음을 알 […]

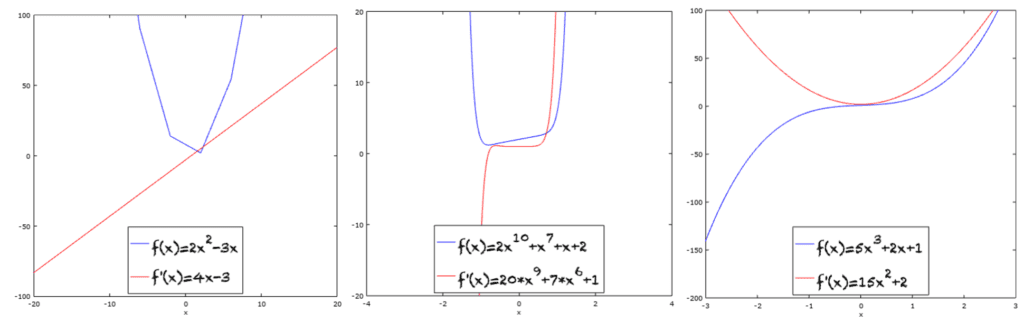

많은 머신러닝 알고리즘의 핵심 프로세스 중 하나인 최적화는 목적 함수를 최대화하거나 최소화하기 위해 모델의 매개변수 값을 업데이트하는 방식을 결정하기 위해 파생 함수를 사용합니다. 이 튜토리얼에서는 함수의 파생물을 찾을 수 있는 다양한 기술을 계속 탐색할 것입니다. 특히, 우리는 첫 번째 원칙에서 모든 미분을 찾아야 하는 것보다 더 빨리 함수의 도함수에 도달하는 데 사용할 수 있는 멱의 […]

머신러닝 및 데이터 과학 알고리즘에서 가장 자주 사용되는 함수 중 하나는 다항식 또는 x의 거듭제곱을 포함하는 함수입니다. 따라서 이러한 함수의 도함수가 계산되는 방법을 이해하는 것이 중요합니다. 이 튜토리얼에서는 x와 다항식의 거듭제곱 도함수를 계산하는 방법을 알아봅니다. 이 자습서를 완료하면 다음을 알 수 있습니다. 다항식의 도함수를 계산하기 위한 일반 규칙 x의 0이 아닌 실수의 거듭제곱을 포함하는 함수의 […]

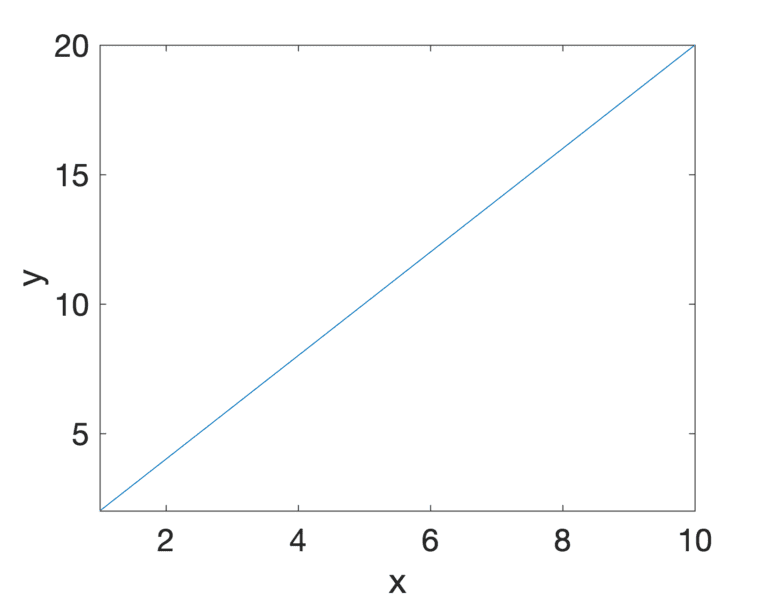

변화율의 측정은 변화와 극소의 수학과 관련된 미분 미적분학의 필수 개념입니다. 이를 통해 두 개의 변화하는 변수 간의 관계와 이것이 서로 어떻게 영향을 미치는지 찾을 수 있습니다. 변화율 측정은 신경망 모델을 훈련하기 위한 최적화 알고리즘으로 경사하강법을 적용하는 것과 같이 머신러닝에도 필수적입니다. 이 튜토리얼에서는 미적분학의 핵심 개념 중 하나인 변화율과 이를 측정하는 것의 중요성을 발견할 것입니다. 이 […]

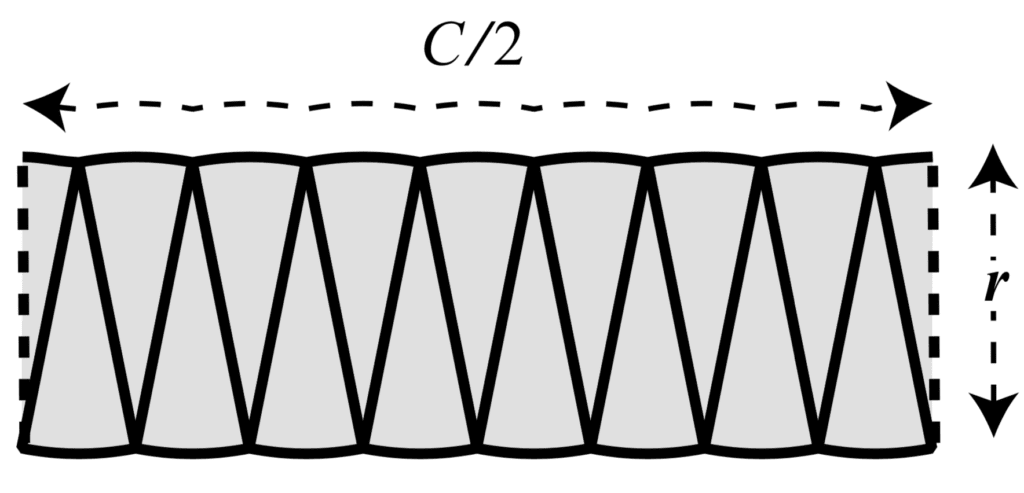

미적분학은 변화에 대한 수학적 연구입니다. 복잡하지만 연속적인 문제를 풀기위한 미적분학의 효과는 문제를 무한히 간단한 부분으로 분할하고 개별적으로 해결한 다음 원래 전체로 재구성하는 능력에 있습니다. 이 전략은 기하학적 모양의 곡률, 비행 중인 물체의 궤적 또는 시간 간격 등 이러한 방식으로 슬라이스할 수 있는 모든 연속 요소를 연구하는 데 적용할 수 있습니다. 이 튜토리얼에서는 미적분학의 기원과 그 […]

딥러닝 신경망 모델은 확률적 경사하강법 최적화 알고리즘을 사용하는 훈련 데이터에 적합합니다. 모델의 가중치에 대한 업데이트는 오류 알고리즘의 역전파를 사용하여 수행됩니다. 최적화 알고리즘과 가중치 업데이트 알고리즘의 조합은 신중하게 선택되었으며 신경망에 적합한 것으로 알려진 가장 효율적인 접근 방식입니다. 그럼에도 불구하고 대체 최적화 알고리즘을 사용하여 신경망 모델을 훈련 데이터 세트에 맞출 수 있습니다. 이는 신경망이 작동하는 방식과 응용 머신러닝에서 […]

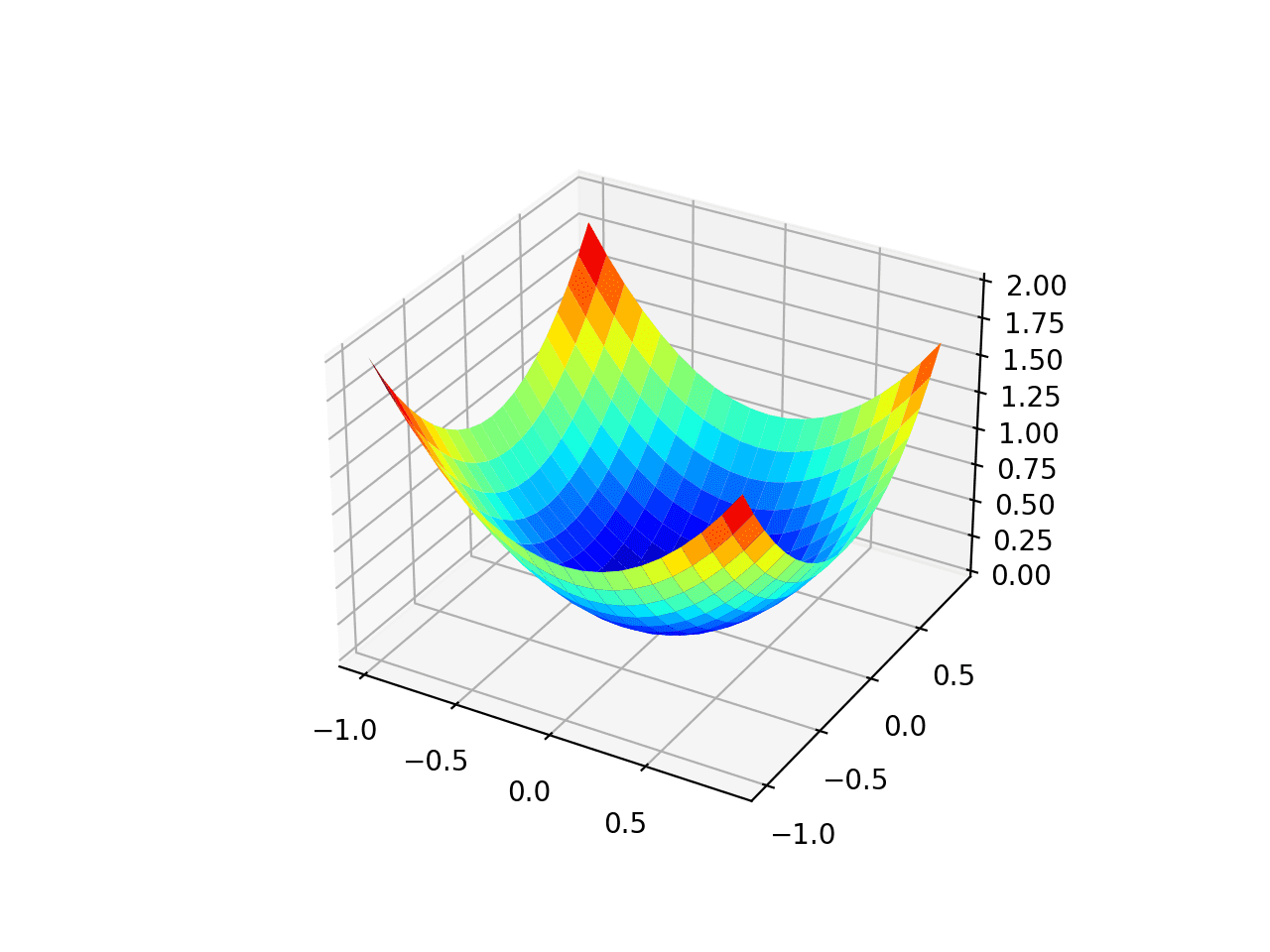

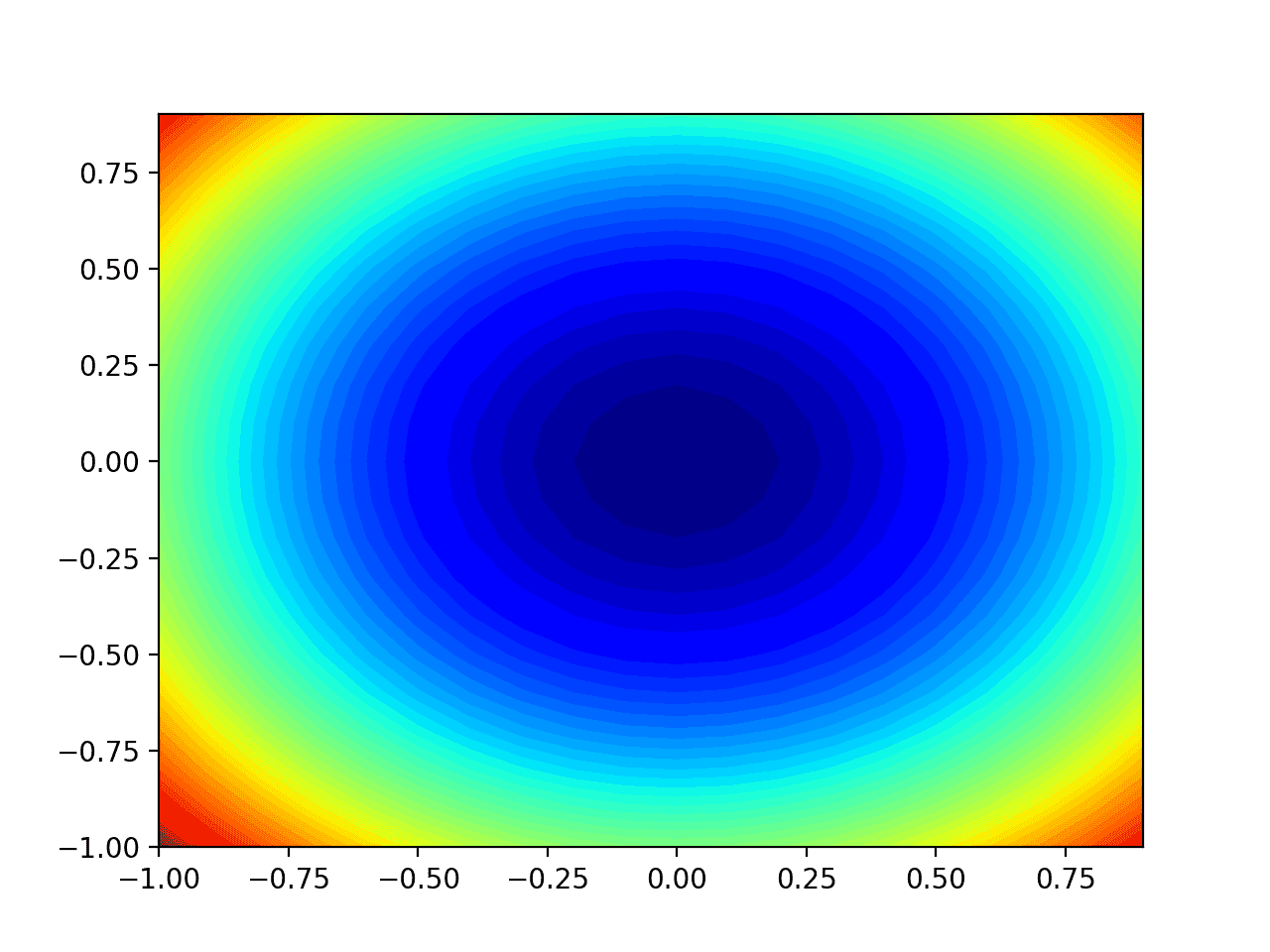

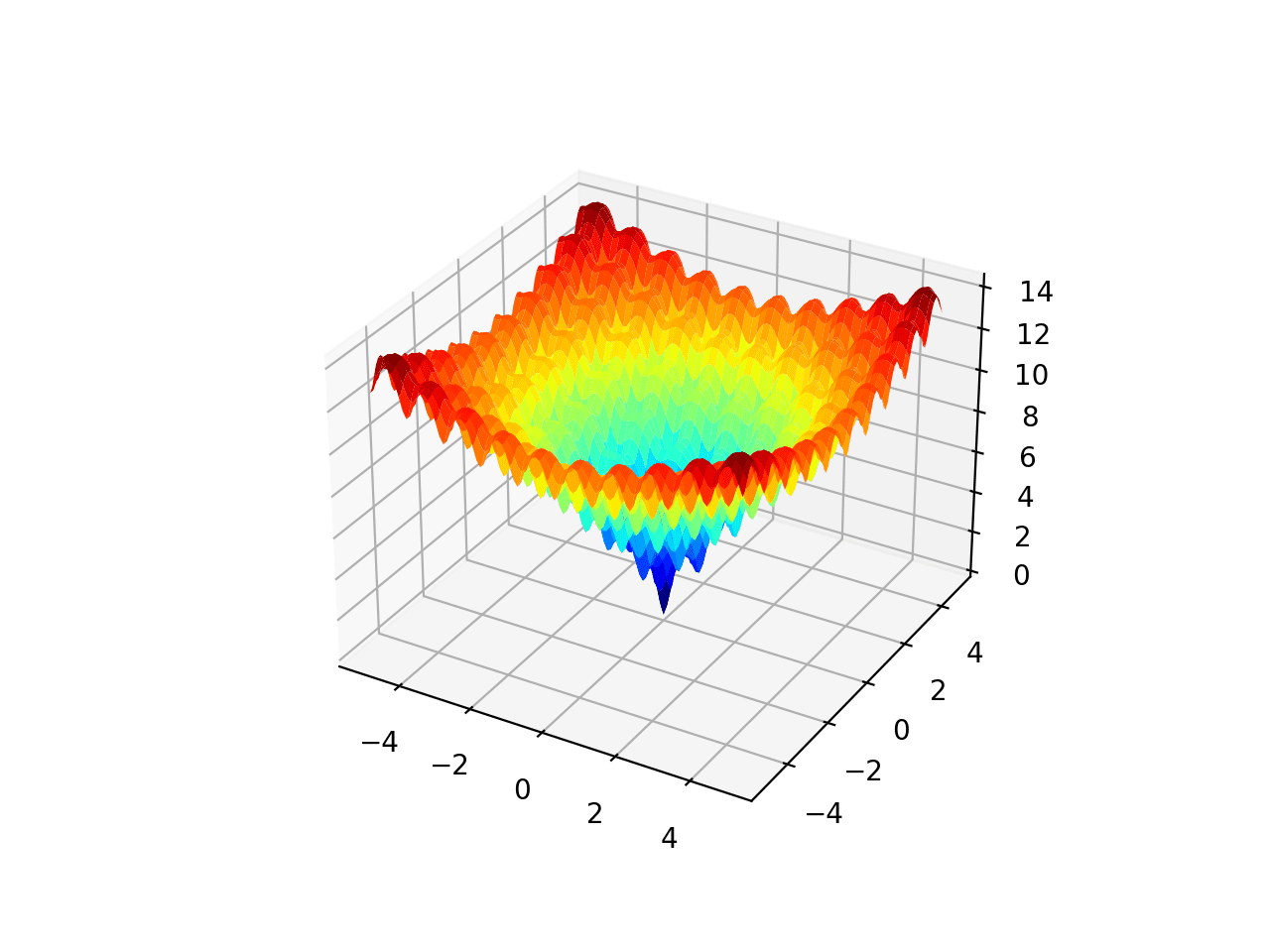

경사하강법은 함수의 최소값을 찾기 위해 목적 함수의 음의 기울기를 따르는 최적화 알고리즘입니다. 경사하강법의 한계는 경사가 평평하거나 큰 곡률이 될 경우 검색 진행이 느려질 수 있다는 것입니다. 업데이트에 약간의 관성을 통합하는 경사 하강에 모멘텀을 추가할 수 있습니다. 이것은 Nesterov의 가속 기울기 (NAG) 또는 Nesterov 운동량이라고하는 현재 위치가 아닌 예상된 새 위치의 기울기를 통합하여 더욱 향상시킬 수 […]

경사하강법은 함수의 최소값을 찾기 위해 목적 함수의 음의 기울기를 따르는 최적화 알고리즘입니다. 경사하강법의 한계는 모든 입력 변수에 대해 단일 단계 크기(학습률)가 사용된다는 것입니다. AdaGrad 및 RMSProp과 같은 경사하강법 확장은 각 입력 변수에 대해 별도의 스텝 크기를 사용하도록 알고리즘을 업데이트하지만 스텝 크기가 매우 작은 값으로 빠르게 줄어들 수 있습니다. 적응형 이동 추정 알고리즘 (Adaptive Movement Estimation algorithm) 또는 […]

차등 진화(Differential Evolution)는 글로벌 최적화 알고리즘입니다. 진화 알고리즘의 한 유형이며 유전 알고리즘과 같은 다른 진화 알고리즘과 관련이 있습니다. 유전 알고리즘과 달리 비트 문자열 대신 실제 값 숫자의 벡터에서 작동하도록 특별히 설계되었습니다. 또한 유전 알고리즘과 달리 벡터 빼기 및 더하기와 같은 벡터 연산을 사용하여 유전학에서 영감을 얻은 변환 대신 검색 공간을 탐색합니다. 이 자습서에서는 차등 진화 글로벌 최적화 […]